评估大型语言模型 (LLM) 的有效性面临重大挑战。在在线聊天机器人竞技场中进行人工注释战斗的方法已被公认为一种非常有效的评估方法。然而,这一过程受到人工注释成本高昂和时间要求的阻碍,使通过后期训练增强 LLM 变得复杂。在本文中,我们介绍了“竞技场学习Arena Learning”,这是一种旨在模拟这些战斗的创新离线策略。我们开发了一套全面的模拟竞技场战斗指令,并使用人工智能驱动的注释来评估战斗结果,通过监督微调和强化学习促进目标模型的持续改进。我们方法的一个关键方面是确保精确评估并实现离线模拟和在线比赛之间的一致性。为此,我们提出了WizardArena,这是一个使用精心设计的离线测试集准确预测各种模型的 Elo 排名的管道。我们的研究结果表明,WizardArena 的预测与在线竞技场的预测非常吻合。我们应用这个新框架来训练我们的模型WizardLM- β,该模型在各种指标上都表现出显著的性能提升。这种完全自动化的训练和评估流程为通过后期训练持续、渐进地改进各种 LLM 铺平了道路。值得注意的是,Arena Learning 在 WizardLM-2 的成功中发挥着关键作用,本文既是对其功效的探索,也是与 WizardLM-2 及其衍生产品相关的即将进行的讨论的基础研究。

介绍

随着各类大模型应用的快速落地和推理成本的降低,企业和消费者对于使用大语言模型服务的兴趣和需求快速增长。同时,随着应用场景的创新和深化,也要求模型不断演进以适应用户新的意图和指令。因此,构建高效的数据飞轮以不断收集反馈并提升模型能力已成为下一代人工智能研究的重点方向。

LMSYS Chatbot Arena 的出现是一个重大进展。这是一个平台,通过在一系列对话挑战中让不同的聊天机器人模型相互竞争,并使用 Elo 评分系统进行排名,促进对不同聊天机器人模型的评估和比较。然而,以人为本的评估过程也带来了自身的挑战:手动安排和等待聊天机器人与人类评估者之间的互动可能非常耗时且耗费资源,从而限制了评估和训练数据开源周期的规模和频率。另一方面,由于优先级限制,大多数模型无法参与竞技场评估,社区最多只能获得 10% 的聊天数据,因此很难直接有效地指导基于该竞技场的目标模型的开发。因此,对更高效、可扩展的基于竞技场的聊天机器人后训练和评估管道的需求变得越来越迫切。

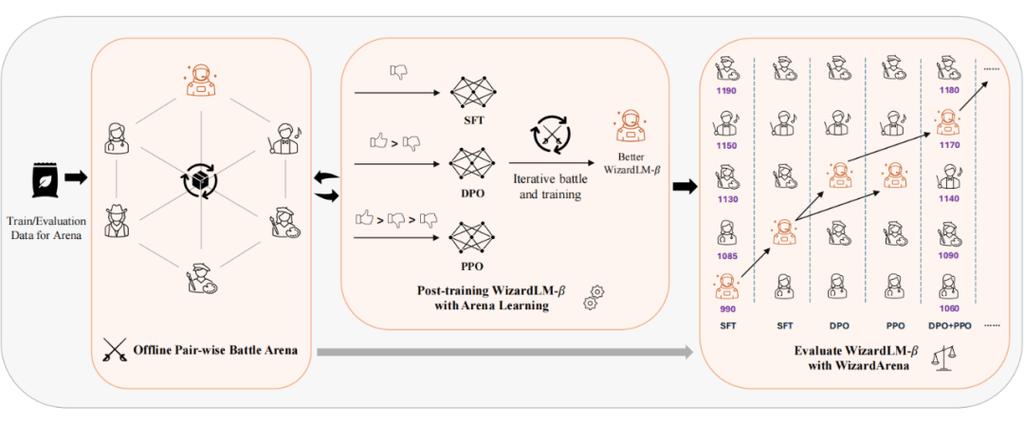

为了应对这些挑战,本文介绍了一种名为 Arena Learning的新方法,这是一种完全基于 AI LLM 并由其驱动的训练和评估流程,无需人工评估员。Arena Learning的主要目标 是构建一个高效的数据飞轮,并减轻与训练后 LLM 相关的人工和时间成本,同时保留基于竞技场的评估和训练的好处。如图 1 所示的运行示例,关键在于 Arena Learning 模拟了一个离线聊天机器人竞技场,并且能够基于强大的“评判模型”高效地预测不同竞技场战斗模型之间的准确性能排名,该模型可以自动模仿人类注释者评判两个模型的响应对的方式,并提供排名、分数和解释。

图1 Arena Learning运行示例

方法概述

在训练后场景中, Arena Learning在大量指令数据上 模拟目标模型(称为 WizardLM-β )与各种最先进模型之间的战斗。然后,这些合成的战斗结果用于通过一些训练策略增强WizardLM-β ,包括监督微调 (SFT)、直接偏好优化 (DPO) 和近端策略优化 (PPO),使其能够从其他优秀模型的优势和劣势中学习。此外, Arena Learning 引入了一个迭代的战斗和训练过程,其中 WizardLM-β 会不断更新并针对 SOTA 模型进行重新评估。这使得 WizardLM-β 能够迭代改进并适应不断变化的竞技场格局,确保它保持竞争力并与该领域最新的顶级竞争对手保持同步。

构建数据飞轮以进行 LLM 后期训练

收集大规模教学数据

为了便于利用模型之间的模拟竞技场战斗来训练 WizardLM-β,Arena Learning 依赖于大规模对话数据语料库 D。数据收集过程涉及过滤、清理和重复数据删除的几个阶段,以确保指导数据的质量和多样性。然后使用模拟竞技场战斗结果为 WizardLM-β 生成训练数据,并针对不同的训练策略进行定制:监督微调 (SFT)、直接偏好优化 (DPO) 和近端策略优化 (PPO)。我们将数据平均分成几个部分 D = { D _0, D _1, D _2, …, D _N},分别用于后续迭代训练和更新。

迭代战斗与模型演化

Arena Learning 采用迭代过程来训练和改进 WizardLM-β。在每一轮模拟竞技场战斗和训练数据生成之后,WizardLM-β 都会使用适当的训练策略(SFT、DPO 和/或 PPO)进行更新。然后将更新后的模型重新引入竞技场,在那里它再次与其他 SOTA 模型进行战斗。这个迭代过程使 WizardLM-β 能够不断改进并适应竞技场不断变化的格局。随着模型变得更强大,模拟战斗变得更具挑战性,迫使 WizardLM-β 突破其界限并从其他模型展示的最新策略和能力中学习。此外,Arena Learning 的迭代性质使研究人员能够随着时间的推移监控 WizardLM-β 的进度和性能,从而提供有关不同训练策略的有效性以及进一步改进或完善的潜在领域的宝贵见解。

使用 WizardArena 评估LLM

在评估场景中,我们首先贡献了精心准备的离线测试集——WizardArena ,它有效地平衡了评估的多样性和复杂性。通过使用 “判断模型”自动化配对判断过程,WizardArena 显著降低了相关成本和优先级限制,并可以生成 Elo 排名和详细的胜/负/平局统计数据。

实验概述

3.1 离线 WizardArena 与在线 LMSYS ChatBot Arena 紧密结合。

图 6 表明,以 LMSYS ChatBot Arena 作为实际场景中的参考基准,WizardArena 显示出良好的排名一致性,而 MT-Bench 则显示出较大的波动。表 3 还表明,离线 WizardArena-Mix 在几个一致性指标上明显优于 MT-Bench:Spearman 相关性高 19.87%,人机一致性提高 73.07%(95% 置信区间),分化提高 74.57%(95% 置信区间)。它与 LMSYS ChatBot Arena 的人机判断平均一致性达到 98.79%,比 Arena-Hard-v1.0 高 8.58%,比 MT-Bench 高 35.23%。相较于使用专有模型(即 GPT-4)作为评判模型的 MT-Bench 和 Arena-Hard-v1.0,我们的方法采用了当前 SOTA 开源模型 Llama-3-70B-Chat,不仅成本显著降低,而且实现了强一致性。此外,融合了 Diverse 和 Hard 测试集的离线 WizardArena-Mix 的平均一致性比 WizardArena-Diverse 高 0.87%,比 WizardArena-Hard 高 0.82%。这表明平衡多样性和复杂性对于有效的大型语言模型离线评估至关重要。上述结果也进一步证明了使用“评判”模型评判 LLM 之间的战斗并在模拟竞技场中生成大量训练后数据的可行性。

3.2 Arena Learning 能否通过后期训练构建有效的数据飞轮?

下表展示了使用 methodname 方法对 WizardLM-beta 模型进行后训练在三次数据飞轮迭代中的效果,其中 I_i 代表第 i 次迭代。在从 I_1 到 I_3 的每次迭代中,我们始终使用 90k 数据进行后训练。从 WizardLM-β-7B-I_0 开始,接下来的 3 次迭代在 Wizardarena-Mix Elo 上分别提高了 343 分、32 分和 28 分。同时,该模型的 MT-bench 分数也获得了显着提升(从 6.41 到 8.16)。具体来说,WizardLM-β-7B-I_1 甚至超越了 WizardLM-70B-v1.0,而 WizardLM-β-7B-I_3 也表现出与 Starling-LM-7B-Beta 相当的性能。值得注意的是,我们在 WizardLM-β-8x22B 模型上也观察到了同样的趋势,甚至在 Wizardarena-Mix Elo(+460)和 MT-Bench(+2.07)上都取得了更显著的提升。该模型还击败了 Command R+ 和 Claude 3 Haiku。下图展示了 32 个模型在 WizardArena-Mix 中的胜率,每个模型参与了 2k x 31 场战斗。与这些基线相比,我们的模型在胜率方面从 I_0 到 I_3 取得了显着的提升。具体来说,以 GPT-4o 为战斗目标,我们的 WizardLM-β-8x22B 的胜率提高了 26%(8% -> 22% -> 27% ->34%),WizardLM-β-7B 的胜率也提高了 14%(6% -> 16% -> 18% ->20%)。

上述结果强调,使用 Arena Learning 与 SOTA 模型持续对抗,并使用新选定的数据更新权重,可以逐步提高模型能力,使其优于竞争对手。因此,Arena Learning 构建了一个有效的数据飞轮,利用 Arena Learning 可以显著提高训练后的模型性能。

3.3 使用竞技场学习扩展迭代 SFT、DPO 和 PPO。

由于本文的核心问题是 Arena Learning 如何通过后训练提高模型的性能,因此在本节中我们将研究不同的后训练技术和数据飞轮迭代对性能的影响。下图展示了 WizardLM-β-7B 模型的结果。正如预期的那样,随着我们从更多 Arena Learning 战斗迭代中添加更多选定数据,SFT 和 RL 模型的性能都在逐步提高。具体来说,从 SFT-I_0 到 PPO-I_3,WizardArena-Mix ELO 分数从 871 提高到 1274,实现了 403 分的巨大提升,Arena-Hard Auto ELO 分数也上升了 26.3 分(从 5.2 分上升到 31.5 分)。此外,AlpacaEval 2.0 LC 胜率提高了 26%,从 8.2% 提高到 34.2%,MT-Bench 得分提高了 1.75 分,从 6.41 提高到 8.16。四个关键基准的显著改进凸显了 Arena Learning 提出的迭代训练方法在 SFT、DPO 和 PPO 阶段增强训练后 LLM 的有效性和可扩展性。

结论

总之,本文介绍了 Arena Learning,这是一个模拟离线聊天机器人竞技场,它利用 AI LLM 消除与训练后 LLM 相关的手动和时间成本,同时保留了基于竞技场的评估和训练的优势。与基于人类的 LMSys Chatbot Arena 相比,Arena Learning 在预测不同 LLM 之间的 Elo 排名方面具有高度一致性,这证明了 Arena Learning 的有效性。此外,在 Arena Learning 生成的合成数据上进行迭代训练的模型在各种训练策略中都表现出显著的性能改进。这项工作展示了 Arena Learning 作为基于人类的评估和数据飞轮平台的经济高效且可靠的替代方案的潜力,可用于训练后大型语言模型。

原文链接https://www.microsoft.com/en-us/research/publication/arena-learning-build-data-flywheel-for-llms-post-training-via-simulated-chatbot-arena/