在ChatGPT引领的AI浪潮下,涌现了一大批AI应用,其背后其实蕴含着一个基本事实:AI能力得到了极大突破——大模型的能力有目共睹,未来只会变得更强。这世界唯一不变的就是变,适应变化、拥抱变化、喜欢变化,天行健君子以自强不息。我们相信未来会有越来越多的大模型出现,AI正在逐渐平民化,将来每个人都可以利用大模型轻松地做出自己的AI产品。

最近这些天,github的排行榜每天都在发生着变化。今天我们要介绍的是今天排在第三名的这个项目—Flowise。

github地址:https://github.com/FlowiseAI/Flowise

(gif上传有些问题,这里用一个本地的截图代替)

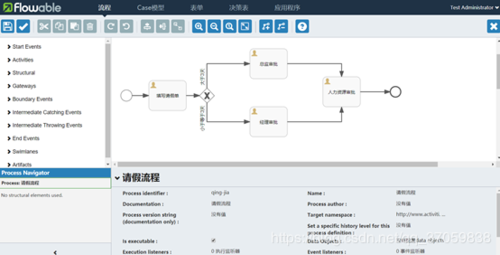

自己探索在推荐这个项目之前,笔者自己先行体验了一下,安装步骤很简单,基本上按下文中的安装步骤就能完成。这里主要展示一下笔者通过这个项目构建的几个LLM流程。

总共构建了下图中的几个流程:

1. ChatPdf

可以用来限定根据pdf里面的相关内容来回答,不过貎似只能英文(大家如果发现可以用中文可以联系一下我)。它的流程如下:

针对pdf流程有疑问的可以参考这篇:https://zhuanlan.zhihu.com/p/627416925

2. SimpleLLMChain一个简单的LLMChain,流程如下:

3. GitHub Repo Q&A

基于github仓库的问答,流程如下:

4. Translator

使用带有聊天提示模板和聊天模型的 LLM Chain 进行语言翻译,流程如下:

5. 聊天模型的会话代理,它利用聊天特定提示和缓冲存储器

流程配置好,点击保存后就可以在右侧的聊天框进行聊天了。

图看不清的可以看下这里:https://www.oschina.net/p/flowise

项目亮点可以通过拖放界面的方式来使用LangchainJS[1]构建定制的LLM流程。

关于LangChain,感兴趣的同学可以翻一下笔者之前写的一篇文章:LangChain 完整指南:使用大语言模型构建强大的应用程序,里面有详细的介绍。

以下是项目的布署安装步骤和说明:

⚡快速开始1.安装Flowise

npm install -g flowise

2.启动Flowise

npx flowise start

3.打开http://localhost:3000即可进入页面。

Docker1.进入项目根目录下的docker文件夹2.创建.env文件并指定PORT(参考.env.example)3.运行docker-compose up -d4.打开http://localhost:30005.若要停止容器,请运行docker-compose stop

开发者Flowise在单一的mono仓库中有3个不同的模块。

•server:用于提供API逻辑的Node后端•ui:React前端•components:Langchain组件

先决条件•安装Yarn

npm i -g yarn

设置

1.克隆仓库

git clone https://github.com/FlowiseAI/Flowise.git2. 进入仓库文件夹

cd Flowise

3. 安装所有模块的依赖:

yarn install

4. 构建所有代码:

yarn build

5. 启动应用程序:

yarn start

现在可以在http://localhost:3000上访问应用程序。6. 对于开发构建:

yarn dev

任何代码更改都会自动重新加载应用程序,可以在http://localhost:8080上访问应用程序。

认证

要启用应用级身份验证,请在packages/server文件夹的.env文件中添加USERNAME和PASSWORD:

USERNAME=userPASSWORD=1234文档即将推出

云托管即将推出

自托管即将推出

支持请随时在讨论区[2]中提出任何问题、报告问题和请求新功能

贡献请参阅贡献指南[3]。如果您有任何问题或问题,请通过Discord[4]与我们联系。

许可证此存储库中的源代码根据MIT许可证[5]提供。

References[1] LangchainJS: https://github.com/hwchase17/langchainjs[2] 讨论区: https://github.com/FlowiseAI/Flowise/discussions[3] 贡献指南: CONTRIBUTING.md[4] Discord: https://discord.gg/jbaHfsRVBW[5] MIT许可证: LICENSE.md