总之,虽然基础模型在推理任务中提供了可能性,但以批判的视角开发和应用它们至关重要。认识到与基于LLM的推理相关的挑战、局限性和风险非常重要。通过这样做,我们可以促进这个领域的进步,确保稳健可靠的推理系统的发展。

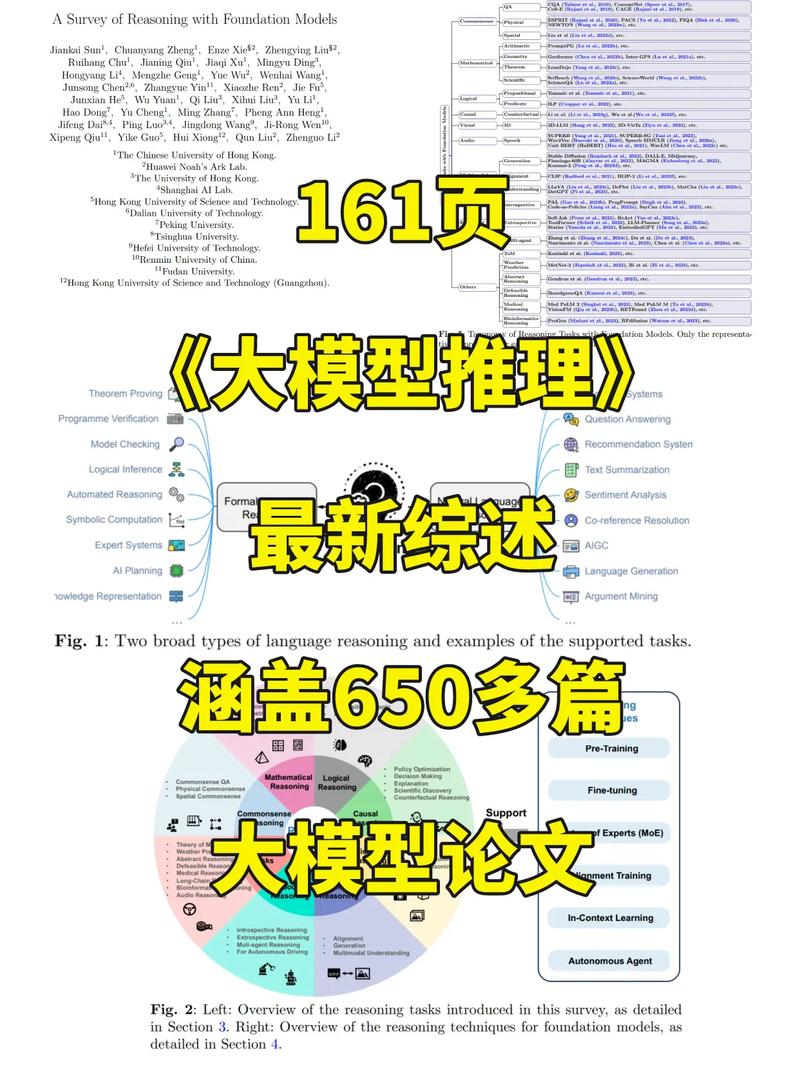

二、论文的简单介绍推理是人工智能的一个关键方面,其应用跨多个领域,如问题求解、定理证明、决策制定和机器人技术。《思考,快与慢》阐明了人类心智的双系统框架,由“系统1”(“System 1)和“系统2”(System 2)思维模式组成。“系统1”运作迅速,依赖直觉、情绪、直觉和无意识过程。相比之下,“系统2”运作更慢,涉及有意识的推敲,如算法推理、逻辑分析和数学能力。推理作为“系统2”的关键功能之一发挥着至关重要的作用。

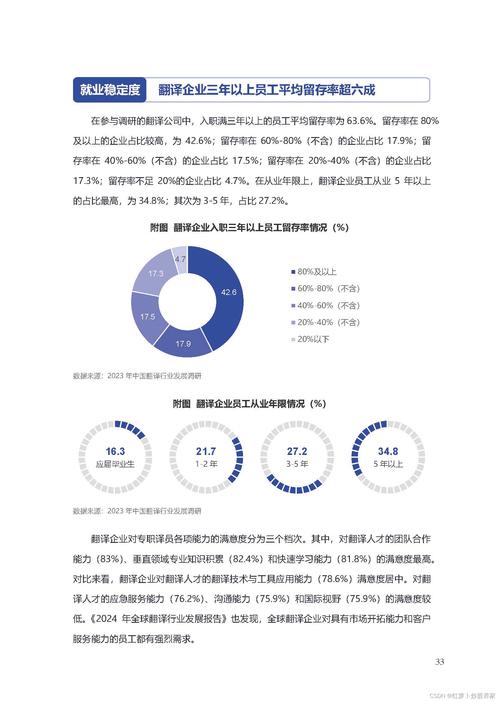

推理可以大致分为两种:形式语言推理(formal language reasoning)和自然语言推理(natural language reasoning )。一方面,如图1所示,形式语言推理通常应用于软硬件系统的形式验证、定理证明和自动推理等领域(automated reasoning)。另一方面,自然语言推理实现更直观的人机交互,支持问题回答、信息检索(information retrieval)、文本摘要(text summarization)和情感分析(sentiment analysis)等任务。

图1:两种广泛的语言推理类型及支持的任务示例

自诞生以来,基础模型( foundation model)在各种领域展现出显著的效果,包括自然语言处理、计算机视觉和多模态任务。然而,对通用人工智能的兴趣,引发了关于基础模型是否能展现人类般的推理能力的争论。因此,对研究基础模型的推理能力的兴趣激增。虽然之前的综述从不同的角度探索了基础模型的应用潜力,但仍需一个系统和全面的调研,专门关注最近在多模态和交互式推理方面的进展,这更贴近人类的推理方式。图2概述了本文将讨论的与推理任务和技术相关的内容。

图2:左:本综述中介绍的推理任务概览,详见第3节。右:基础模型的推理技术概览,详见第4节

基础模型通常由数十亿个参数组成,并通过自监督学习self-supervised learning)在大规模数据集上进行(预)训练。一旦(预)训练完成,基础模型可以通过特定任务的微调、线性探测(linear probing)或提示工程进行调整,以解决许多下游任务,展现出显著的泛化能力和出色的准确性。与传统transformer中使用的软注意力机制(soft attention mechanisms)相比,系统2注意力(System 2 Attention,S2A)利用大语言模型(LLM)的能力来促进语言推理。这种方法提高了长篇内容生成的事实性和客观性。通过将逻辑规则和原则整合到学习过程中,这些模型可以执行诸如推理和演绎等复杂任务。这使得它们能够根据明确的知识和逻辑推理进行决策,而不仅仅依赖于统计模式(statistical patterns)。作为人工智能研究领域中的快速发展领域,基础模型推理旨在开发能以更人性化的方式理解和处理复杂信息的模型。基于逻辑推理和知识表示的基础之上,这些模型使抽象概念推理和基于逻辑规则进行决策成为可能。

首先,基础模型推理实现了先验知识和领域专业知识的应用。逻辑规则可以从专家知识中推导出来,或从现有的本体或知识图谱中形式化。通过利用这些先验知识,模型可以从对问题领域的更好理解中受益,并做出更明智的决定。其次,基础模型推理可以增强健壮性和泛化能力。通过合并海量数据中包含的信息,模型可以更好地处理面临有限数据或在部署中遇到未见场景的情况。这使得模型能够更可靠和稳健地应用于复杂的真实世界环境。与目前主要关注基础模型特定方面的调研形成对比,例如提示、幻觉、演绎推理、逻辑推理、因果推理、健康信息学或AIagents,论文采取更广泛的视角,旨在以内聚的方式关联这个领域的各种研究工作。如图2所示,论文简要概述了各种推理任务,包括常识推理、数学推理、逻辑推理、因果推理、视觉推理、音频推理、多模态推理、具身推理、可辩驳推理等。通过这种方式,论文提供了一个全面的概述,突出了该领域不同方面的互联关系,以激发更多研究工作积极参与和推进基础模型的推理进步。

总之,论文调研了650多篇关于基础模型的论文,主要关注过去两年的研究:

论文讨论了这些模型中使用的不同任务、方法、技术和基准。论文还探讨了各种可以从基础模型推理中受益的应用领域,如问答、自动推理和知识表示。论文还讨论了当前基础模型推理的挑战和局限性以及未来研究的潜在方向。通过理解这个领域的进步和挑战,研究人员可以探索开发能以更人性化和可解释的方式推理和决策的智能系统的新途径。总体而言,论文旨在对基础模型推理提供一个全面的理解,包括其当前状态和未来可能性。

表1:来自Social IQA的常识推理问题示例。正确答案用粗体表示

表2:数学文字题示例

表3:演绎推理、归纳推理和归纳推理的说明。在这个例子中,黑色文本表示给定的知识,而红色文本表示推断出的知识。“事实”表示具体信息,而“规则”表示一般原则或指南

图3:基础模型可以主要分为语言、视觉和多模态基础模型,每种都是一个活跃的研究领域

图4:过去两年arXiv上“大语言模型推理”论文数量的变化趋势。它描绘了研究兴趣的上升趋势,2023年的文章数量显著激增

不同类别的推理方法和任务:

常识推理:探索推断和应用日常直观知识的能力。数学推理:关注解决数学问题和得出逻辑结论的能力。逻辑推理:检查基于形式逻辑进行推理和决策的过程。因果推理:调查对因果关系及其影响的理解。多模态推理:涉及跨文本、图像和传感信息等多种数据模式的推理。视觉推理:关注需要解释和操作视觉数据的任务。具身推理:探索在具身代理与其环境交互的上下文中的推理。其他推理任务:推理讨论扩展到各种上下文,包括抽象推理、可否定推理,以及医学推理、生物信息学推理等应用领域。我们还强调了长链推理在应用中的巨大效用供研究人员探索。这一全面的概述对该领域的多样化推理任务和方法提供了洞察。每个推理领域的突破性工作汇总可在图5中找到。

图5:基础模型推理任务Taxonomy。仅列出了每种任务类型的代表性方法。

图6:基础模型在常识推理方面的三个研究领域。(a) 通过理解日常知识,基础模型可以推理问题中的隐含知识并推导出答案。(b) 基础模型从一般物理知识中推断出广泛的物理特性。(c) 基础模型从一组对象推理空间特性。

图7:提高大语言模型逻辑推理能力的两种主要方法。(a)上下文学习利用特定提示作为演示来引发逻辑推理。(b)微调使用额外的训练样本来更新专门模型的参数。

表4:命题逻辑和谓词逻辑在基本元素、复杂性、表达能力和应用方面的比较。

图8:反映不同因果推理任务的因果图示例。(a) 因果发现识别给定系统中变量之间的潜在因果关系。(b) 效应推断基于已知的因果关系,估计对系统的特定干预的结果(例如重量)。(c) 归因确定特定原因对给定效应的责任程度。(d) 判断基于感知的因果关系的后果和暗示进行决策。

图9:通用视觉系统G-VUE(Huang等,2023b)的四个功能域及相应的视觉任务。

图10:SUPERB(Yang等,2021)的四个评估领域专注于基础模型的辨别能力及对应的任务。PR:电话识别,ASR:自动语音识别,KS:关键词识别,QbE-STD:示例查询的语音术语检测,SID:说话者识别,ASV:自动说话者验证,SD:说话者二元化,IC:意图分类,SF:槽填充,ER:情感识别。

图11:多模态推理任务可以广泛分为图像-文本Alignment、文本到图像生成、多模态到文本生成和多模态理解。当前的多模态基础模型主要涉及三项关键技术来实现推理任务,包括多模态指令调谐、多模态上下文学习和LLM辅助视觉推理。图形式来源于教程(Li,2023)。

图12:内省推理和外观推理的区别。内省推理不需要与环境交互,而外观推理利用来自外部环境的观察和反馈来调整计划。图形式来源于工作(Qin等,2023)。

图13:单agent推理和多agent推理的区别。

表5:常识推理基准统计。Choices:每个问题的选择数;Questions:问题数量。

表6:逻辑推理基准Lu等(2023d)。有三种任务类型:多项选择题回答(MCQA);自然语言推理(NLI);事实验证(FV)。

表7:音频推理任务指标。这里“Cat.”表示任务类别。“discr.”和“gen.”代表判别和生成任务。

表8:部分推理数据集汇总1

表9:部分推理数据集汇总2

图14:用于预训练基础模型的数据源和数据集,主要包括文本数据、图像数据和多模态数据。

图15:编码器-解码器框架(左)和仅解码器框架(右)示意图。图来源于(Fu等,2023c)。

图16:不同参数高效训练方法示意图。(a) 低秩调适(LoRA)保持预训练模型的原始权重不变,同时在网络的每一层中整合基于秩分解的可训练矩阵来调整参数。图来源于LoRA(Hu等,2022)。(b) 提示调谐在输入层加入可训练提示向量,并使用提示增强的输入来解决特定下游问题。(c) SSF仅需要缩放和移动预训练网络提取的深度特征进行参数高效微调。图来源于SSF(Lian等,2022)。(d) MMA训练轻量适配器以弥合大语言模型与视觉语言任务之间的差距,实现视觉和语言模型的联合优化。图来源于MMA(Luo等,2023b)。

图17:大语言模型(LLM)Alignment训练过程。首先,LLM通过使用高质量指令数据进行监督微调(SFT)进行常规优化。然后,它可以通过人类偏好训练进行进一步调整。相关技术包括需要增强学习的在线人类偏好训练(左)和直接优化策略以最好地满足偏好的离线方法(右)。

图18:循环语言模型中的混合专家(MoE)层。在这种情况下,我们采用稀疏门控函数选择一对专家来执行所需的计算。图来源于(Shazeer等,2017)。

图19:上下文学习的常见技术。

图20:具有自治agent的LLM的一般流程。LLM agent将LLM作为其数字大脑,掌握多种能力并具有高水平的智能。agent可以接收各种编码的数据作为输入,并相应地构建或访问知识库和技能库。有了足够的知识和提示,agent可以半自主地操作一系列任务。

论文标题:A Survey of Reasoning with Foundation Models

论文链接:https://arxiv.org/abs/2312.11562v4