拥有权利的同时也被赋予了重大的责任。 正如Facebook和Cambridge Analytica丑闻的细节所揭示的那样,IT行业仍在努力如何应对道德困境的问题。

首先,不要伤害。 这是希波克拉底誓言的基本信息,历史上由医生采用,表明他们将遵守道德行为准则。 管道工,施工人员,执法人员--几乎任何工作影响公众的专业人士都必须遵守某种道德行为准则。

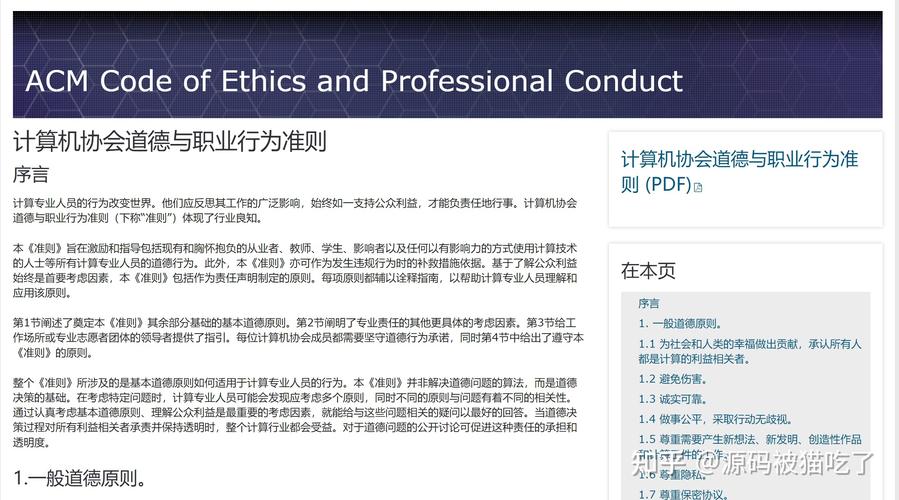

有一个相当显着的例外:技术。 虽然有组织和公司特定的行为准则--例如计算机械协会(ACM)和电气和电子工程师协会--计算机科学(IEEE-CS)软件工程道德专业实践联合工作组的这些准则,没有包含整个行业的全套标准。 也许这是因为Yonatan Zunger在波士顿环球报上写道:“......与其他科学不同,计算机科学领域尚未面临其从业人员所做工作的严重负面影响。”

但是,鉴于剑桥Analytica在帮助客户操纵选民的软件构建方面的作用仍在出现,这些细节可能即将改变。计算机科学和软件开发过去一直困扰着伦理问题,但似乎这些问题不仅发生得比较频繁,而且规模和影响也在不断增加。

2015年,独立测试显示大众汽车的工程师编程了汽车来欺骗排放标准。在2016年美国总统大选之后,Facebook等公司正在努力应对虚假的流行,现在与剑桥分析公司对个人用户信息的武器化密不可分。美国正在努力应对俄罗斯黑客攻击和干涉我们的选举,以及Twitter和Facebook等社交媒体平台所扮演的角色。现任总裁竞选承诺在现有(或建立一个新的)穆斯林登记机构的基础上进行追踪,以追踪那些信仰的成员。

善与恶?

这些只是几个软件如何用于恶意目的的例子;没有办法明确地了解每一项技术和每一行代码的开发和使用的每种可能结果。所以,那些设计和构建我们每天用来做正确事情的产品,软件包,应用程序和解决方案的人都应该参与其中。这是很大的压力。

如果你被迫按时完成任务,或者你的生计处于紧迫状态,你也很难驾驭对与错。培训公司Scrum.org的产品负责人Dave West表示,道德规范可以为专业人士提供背景和框架。虽然他希望看到这样的事情,但他说这样一个多元化思维团体可能无法就这样的代码所涉及的所有方面达成一致是可以理解的。

“我很想看到一个标准化的行业道德规范;我们确实拥有属于我们改善制作软件专业的使命。它的核心是我们开放,勇气,尊重,专注和承诺的五大价值观。我们认为,如果任何人不能确定自己的工作职责的任何部分,他们就会坚定地打下基础,因为他们可以退后一步,看看这些价值观,并说'我做对了吗? ,基于我相信的这些东西?“West说。

只要这个行业一直存在,关于软件开发伦理的争论就激烈起来。招聘公司HiringSolved的创始人兼首席执行官Shon Burton说,评估一项技术的所有潜在应用程序(好的和坏的)都是几乎不可能的,这个应用程序使用AI来帮助公司识别多样的人才。

任何工具都可以成为武器

“任何工具都可以成为武器,具体取决于你如何使用它。没有办法知道技术的每一种可能的应用。对于我们来说,使用人工智能和自动化 - 现在我们可以考虑的东西,现在我们已经接近它,我可以看到好的和坏的,并且都可以轻松访问。对于我们的应用程序,我们可以帮助客户筛选各种候选人。但我们也看到,它可以用来筛选具有不同种族,种族,性别的人。我们内部有一套我们都遵守的行为准则。但我们了解潜在的和意想不到的后果,“伯顿说。

Zunger写道:“如果安全第一,由剑桥分析公司使用的Facebook Graph API,从2010年首次推出的那一刻起就引发了工程师们的广泛恐慌,可能永远都看不到白天。

在缺乏全行业道德标准的情况下,个人甚至一些企业实体都在公开表达自己的价值观。去年12月,NeverAgain.tech运动发布了一个承诺,抵制“......根据受宪法保护的宗教信仰建立人员数据库。我们拒绝促成政府认为不受欢迎的人群的大规模驱逐行为,“祈愿写道。现在收集了超过2500个签名。

GrubHub首席执行官马特·马洛尼为反对可恶,贬低和歧视性行为和语言的立场付出了很多热情。甲骨文公司执行官乔治波利斯纳公开辞去了他的职位,以回应他的前雇主的联合首席执行官在即将到来的总统行政当局接受角色。

在这种情况下,即使你正在行走,也很难知道对与错之间的界限。 Scrum.org的West说,尽管一个标准化的道德规范可能是一个解决方案,但教人们如何提出正确的问题可能更重要。

“就我个人而言,我很乐意看到更多的教学方面的教育比目前所能提供的更多,特别是在专业方面,而不仅仅是一门关于理论的课程,因为除非它是更广泛的专业标准的一部分,否则孤立的伦理学将无法运作。但是,也存在一个问题,即人们通常不能单独构建软件,他们也没有一次性做出这些“错误”的决定,而是逐渐做出决定,“West说。

这些问题应该围绕它应该建立,什么是故障保险箱,我们可以做些什么来确保我们可以产生最小的有害影响?

- Shon Burton

伯顿说,教人们问正确的问题涉及到对问题的理解,并且每个人的价值观都不一样;一些人在使用运行核反应堆的软件或开发无人机,智能炸弹或军事技术的瞄准系统方面没有问题。

“事实是,我们之前就到过这里,而且我们已经在缓解风险和意外后果方面取得了进展。我们知道我们必须非常小心如何使用这些技术。这甚至不是我们能够建立它的问题,因为我们知道技术和能力是在我们能想到的。这些问题应该围绕它应该建立,什么是故障保险箱,我们可以做些什么来确保我们可以产生最小的有害影响?“他说。

伯顿认为,尽管反对者认为人工智能,机器学习和自动化实际上可以帮助解放这些道德问题,释放人类以更充分地考虑他们正在构建的技术的影响。

Burton说:“现在,要满足最后期限和发布产品的市场压力,以及开发人员,CIO,CTO和其他IT领导者的时间,都面临着巨大的压力。” “如果我们能够实现更多的流程自动化,并减轻一些人的努力,这样他们就可以应用更好的批判性思维,并希望在这些问题得到批判之前将其中的一些问题避开,”他说。

这里没有一个“正确的答案”,一个道德规范当然不会把所有的道德问题都搁置下来。但如果个人和组织希望利用技术的巨大能量来创造更好的解决方案,那么它可能是一个开始的好地方。