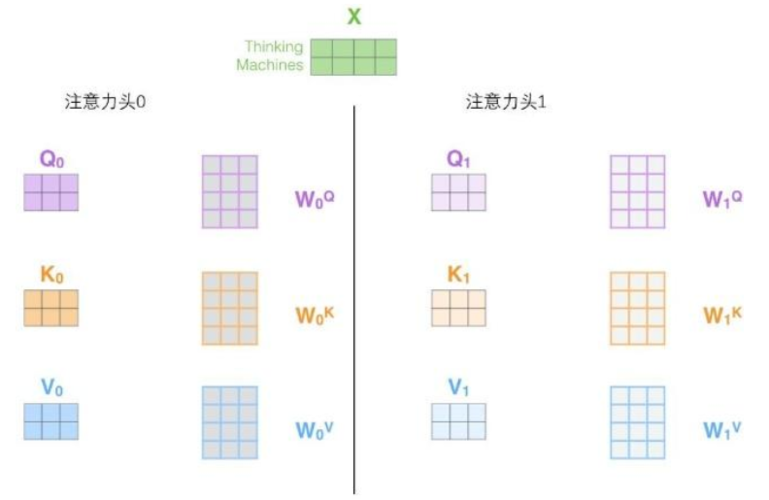

以下是Wq, Wk, 和 Wv 权重矩阵在多头注意力中通过模型学习得到的过程:

1. 初始化:

- 在训练开始时,多头注意力模型中的Wq, Wk, 和 Wv 权重矩阵会被随机初始化。每个注意力头都会有自己的一组Wq, Wk, 和 Wv 权重矩阵,因此会有多组这些权重矩阵。

2. 前向传播:

- 在训练过程中,输入数据会通过每个注意力头的Wq, Wk, 和 Wv 权重矩阵进行线性变换,得到每个注意力头的查询(query)、键(key)、和数值(value)向量。

3. 多头并行计算:

- 每个注意力头会并行地进行自注意力计算,计算出多组注意力权重和注意力表示。这意味着每个注意力头对输入数据的理解和表达都是独立的。

4. 合并表示:

- 每个注意力头计算得到的注意力表示会被合并起来,得到最终的多头注意力表示。这个合并过程可以是简单的拼接或加权求和等方式。

5. 损失计算和反向传播:

- 模型根据多头注意力表示进行进一步的计算,然后将计算结果与真实标签进行比较,计算出模型预测的损失值。接着利用反向传播算法计算梯度,并通过优化算法来调整每个注意力头的Wq, Wk, 和 Wv 权重矩阵,以最小化损失值。

6. 迭代优化:

- 上述步骤会在整个训练数据集上进行迭代,模型不断地通过反向传播算法和优化算法来调整每个注意力头的Wq, Wk, 和 Wv 权重矩阵,使得损失值最小化。

通过这个训练过程,多头注意力模型会逐渐学习到每个注意力头的合适的Wq, Wk, 和 Wv 权重矩阵的取值,使得模型能够更好地理解输入序列中的关系和语义信息,并且能够并行地学习不同的表示。最终,这些权重矩阵会包含模型在训练数据上学习到的知识,使得模型在处理新的输入数据时能够更加准确地进行推断和预测。