数据预处理: 将不同模态的数据统一格式,确保能够输入到模型中。

模型设计: 使用适当的深度学习架构,如融合型(Fusion-based)或并行型(Parallel-based),将不同模态的信息整合在一起。

训练和微调: 利用多模态数据进行模型训练,并通过微调来适应具体任务。

可以尝试使用以下方法:

填充(Padding): 在视觉模型的输出中添加适当数量的填充,使其长度与语言模型的输出一致。

剪裁(Trimming): 在语言模型的输出中剪裁一部分,使其长度与视觉模型的输出一致。

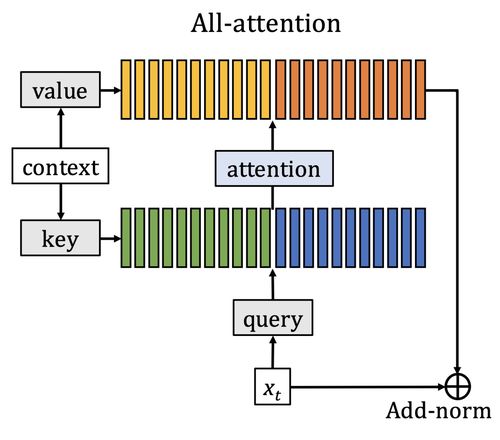

使用注意力机制: 在模型设计中,可以使用注意力机制来动态地对不同模态的信息进行权重分配,从而处理不同长度的输出。

6、介绍一下transformerTransformer的核心思想是自注意力机制(self-attention),它允许模型在处理序列数据时关注输入序列中的不同位置,而无需依赖于序列的顺序。Transformer包括编码器(Encoder)和解码器(Decoder),每个编码器和解码器块都包含多头注意力机制和前馈神经网络。

7、transformer的输入和输出分别是什么输入: Transformer的输入是一个序列,如文本中的一句话。每个词(或标记)都会被嵌入成一个向量,并加上位置编码,形成输入序列。

输出: Transformer的输出是对输入序列中每个位置的预测,或者是整个序列的表示。在机器翻译等任务中,输出通常是目标语言的对应序列。

8、transformer的输出和bert有什么区别Transformer输出: 在标准的Transformer模型中,输出是由解码器的最终层产生的,通常是一个表示整个序列的向量。这个向量可以用于各种任务,如文本分类、生成等。

BERT输出: BERT(Bidirectional Encoder Representations from Transformers)是基于Transformer的预训练模型,主要用于学习丰富的上下文语境。BERT的输出不仅包含了整个序列的向量,还包括了每个输入词的上下文相关表示。BERT的预训练阶段包括两个任务:Masked Language Model(MLM)和Next Sentence Prediction(NSP)。

总的来说,BERT的输出更注重于每个词的上下文相关表示,而标准的Transformer输出更倾向于整个序列的表示。

9、介绍一下注意力机制注意力机制是深度学习模型中一种关键的机制,用于处理序列数据时更灵活地关注不同位置的信息。在Transformer中,注意力机制通过自注意力机制实现。

自注意力机制(Self-Attention): 给定一个输入序列,自注意力机制通过对序列中每个元素计算权重,然后将这些权重加权求和得到输出。这个权重表示了模型对输入中不同位置的关注程度。具体来说,对于每个位置,通过计算与其他位置的相似度得到一个权重,最后将这些权重应用于输入序列上。这使得模型能够同时关注序列中的多个位置。多头注意力机制(Multi-Head Attention): 为了提高模型的表达能力,Transformer引入了多头注意力机制,允许模型学习多组不同的注意力权重。每个注意力头都产生一个输出,最后通过线性变换和拼接得到最终的多头注意力输出。注意力机制的引入提高了模型处理序列数据的能力,使得模型能够更好地捕捉上下文信息。

看完本篇如果对你有用请三连,你的支持是我持续输出的动力,感谢,笔芯~ ↓ ↓ ↓以下12本书电子版免费领,直接送 ,想要哪本私我下说声,我发你↓ ↓ ↓

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

以上8本+《2022年Q4面试题-69道》、《2022年Q3面试题-83道》、《2023年Q1面试题-65道》、《2023年Q2面试题-103道》共12本,免费送